Apache Hudi 统一批处理和近实时分析的存储与服务解决方案

随着大数据技术的发展,企业对数据处理的需求日益多样化,既需要高效的批处理能力,也期望能够实现低延迟的近实时分析。Apache Hudi(Hadoop Upserts Deletes and Incrementals)作为一种高效的数据湖存储框架,通过其独特的设计理念和功能,为批处理和近实时分析提供了统一的存储与服务解决方案,并在信息处理和存储支持服务领域发挥了重要作用。

一、Apache Hudi 的核心特性与统一存储架构

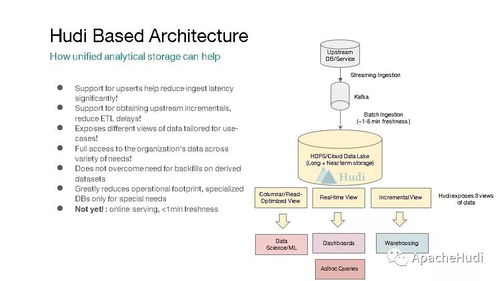

Apache Hudi 是一个开源的分布式数据存储系统,构建在 Hadoop 生态系统之上,专注于支持数据的增量更新、删除和增量查询。其核心特性包括事务支持、快照隔离、数据版本管理以及自动压缩机制。通过这些特性,Hudi 能够实现数据的近实时摄取与处理,同时保持与批处理工作负载的兼容性。例如,Hudi 支持两种表类型:Copy-on-Write(写时复制)和Merge-on-Read(读时合并)。Copy-on-Write 模式在写入时直接更新数据文件,适用于频繁查询的场景;而 Merge-on-Read 模式则允许数据在写入时暂存为增量日志,随后在读取时合并,从而优化写入延迟,满足近实时分析需求。这种灵活的架构使得 Hudi 能够统一处理批量和流式数据,减少数据冗余和存储成本。

二、批处理与近实时分析的一体化服务

在传统大数据架构中,批处理和流处理往往采用不同的存储系统,例如使用 HDFS 进行批处理,而 Kafka 或 Flink 处理实时流。这种分离导致数据孤岛、管理复杂性和延迟问题。Apache Hudi 通过提供统一的服务层,解决了这些挑战。它支持增量数据处理,允许用户以微批或近实时的方式摄取数据,同时提供高效的查询接口,如 Apache Spark、Presto 和 Hive 的集成。例如,企业可以利用 Hudi 的增量拉取功能,仅处理自上次批处理以来的新增数据,从而加速 ETL 流程;通过近实时数据摄取,Hudi 能够在秒级延迟内提供最新数据,支持仪表板、风控和实时推荐等应用。这种一体化服务不仅简化了数据管道,还提升了数据新鲜度和处理效率。

三、信息处理和存储支持服务的应用优势

Apache Hudi 在信息处理和存储支持服务方面具备显著优势。它提供了事务性保证,确保数据的一致性和可靠性,这在金融和电商等关键领域尤为重要。Hudi 的数据版本控制和快照功能,使得用户可以回溯历史数据状态,支持审计和合规需求。Hudi 的自动数据管理功能,如文件大小优化和清理旧版本,降低了运维负担。在实际应用中,许多组织已采用 Hudi 来构建数据湖,例如在 Uber 的出行数据平台中,Hudi 帮助实现了大规模数据的近实时更新和分析,显著提升了业务响应速度。通过整合批处理和近实时分析,Hudi 不仅优化了存储资源,还提供了灵活的数据处理能力,支持从离线报表到实时监控的全方位信息服务。

Apache Hudi 通过其创新的存储架构和统一的服务模式,成功弥合了批处理与近实时分析之间的鸿沟。它不仅提高了数据处理效率,还强化了信息处理和存储支持服务的可靠性与可扩展性。随着企业对实时洞察需求的增长,Hudi 有望在数据湖生态中扮演更重要的角色,推动大数据技术的进一步发展。

如若转载,请注明出处:http://www.xympsk.com/product/5.html

更新时间:2026-03-03 06:00:39